ヤンマーホールディングス株式会社

デジタル本部 AI戦略推進部

ヤンマーテクニカルレビュー

AIとエッジコンピューティング技術を用いた農作業支援技術の開発

~誰でも簡単な農業を目指して~

Abstract

With the recent trend toward larger farm sizes and corporate ownership, producer organizations increasingly employ workers instead of relying on farm managers to perform tasks directly. As many of these workers lack experience, there is a growing need for task support technologies that enable consistent and efficient operations regardless of individual skill levels. In small-scale farming, the difficulty of transferring tacit knowledge to successors presents an additional challenge, highlighting the necessity for standardized criteria to guide decision-making. To address these issues, Yanmar has been developing agricultural support systems utilizing image recognition-based artificial intelligence (AI). This paper discusses the unique challenges associated with implementing image recognition AI in agricultural environments and presents solutions to these challenges, along with case studies demonstrating its practical application.

1. はじめに

近年、農業の大規模化・法人化に伴い、作業者を雇用する生産者組織が増加している(1)。農業の未経験者を雇用するケースも増えており、作業者の作業品質の均質化が課題となっている。このような背景から、従来のように個人の勘と経験に依存することなく、誰でも同じ基準で一定以上の品質で作業が可能となるよう、作業者への支援技術が望まれている。収穫作業と選別作業は作業時間に占める割合が特に高いため、支援が実現すれば農業経営全体で大きな効果が期待できる。

当社では解決策の一つとして、画像認識AI(Artificial Intelligence)を搭載した農作業支援システムを提案し、技術開発を進めている。画像認識AIはその場で得られた画像に対して一定の基準で判断を行い、その判断結果を農作業支援情報として作業者に提示することができる。 農業の現場での利用を考慮すると、システムには作業の邪魔にならないことと、システム全体が山間部などの電波が届きづらい環境でも動作することが求められる。そこで本システムでは、スマートグラスおよび農業の現場に設置可能な小型演算装置(エッジデバイス)を用いた構成により、ハンズフリーで、電波状態に依存せず、様々な環境で利用できるようにした。以下、課題解決のためシステムに採用した技術とその適用事例について述べ、開発の進捗状況と今後の展望を示す。

2. 課題解決のための技術

2.1. 画像認識AI

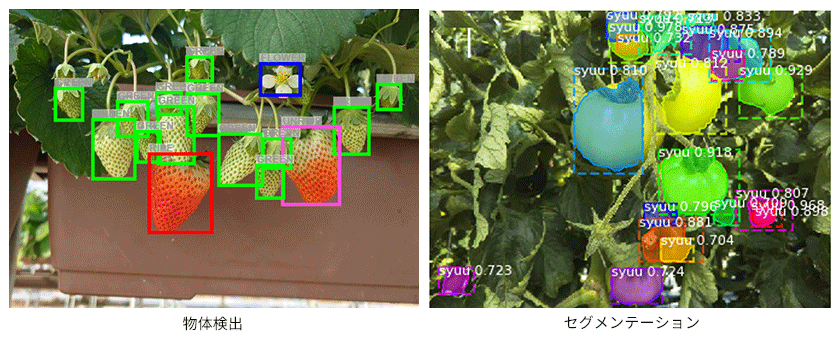

画像認識AIは、1枚の画像全体が何を表しているかを判定する「画像分類」、画像内の複数の物体を検出してそれぞれの位置とクラスを判定する「物体検出」、画像内のピクセルが何のクラスに属するかを判定する「セグメンテーション」に大別される。農業の現場で得られる画像には複数個の作物が写っているため、物体検出またはセグメンテーションが適している。一般に物体検出よりもセグメンテーションの方がAIモデルの容量が大きく結果を得るのに時間がかかるため、実現したい機能に作物の詳細な形状情報が不要な場合は物体検出を、必要な場合にはセグメンテーションを用いた(図1)。

2.1.1. 色味判定

物体検出モデルで作物の形や色を判別してクラス分けを行うことにより、作物の色味を多段階で判定することが可能である。農業においては判定した色味に基づき作物の熟度を推定することができ、この機能を利用することにより未習熟者であっても収穫の判断ミスを低減することが可能である。

2.1.2. 形状判定

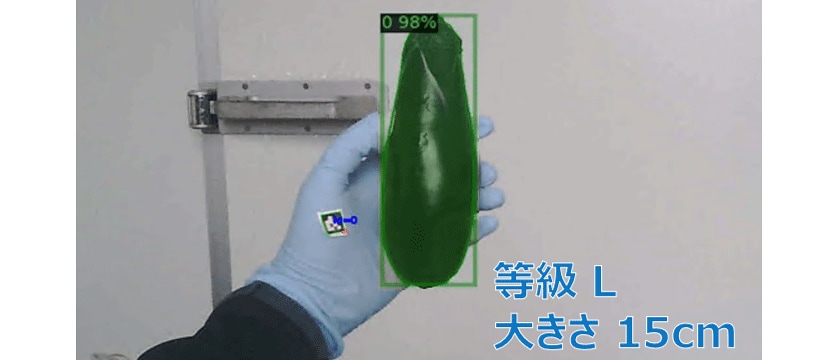

セグメンテーションモデルでは画像の各ピクセルに対してクラス分類が行われるため、物体の輪郭、縦横の長さ、表面積などの形状情報をピクセル数で定量的に得ることができる。画像のスケールを知ることができれば、ピクセル数を基に物体の実サイズを算出することが可能である。当社では、作業者の手袋に寸法が既知のAR(Augmented Reality)マーカを貼付し、その寸法と作物のピクセル数を比較して作物の実サイズを推定する手法を考案した(図2)。

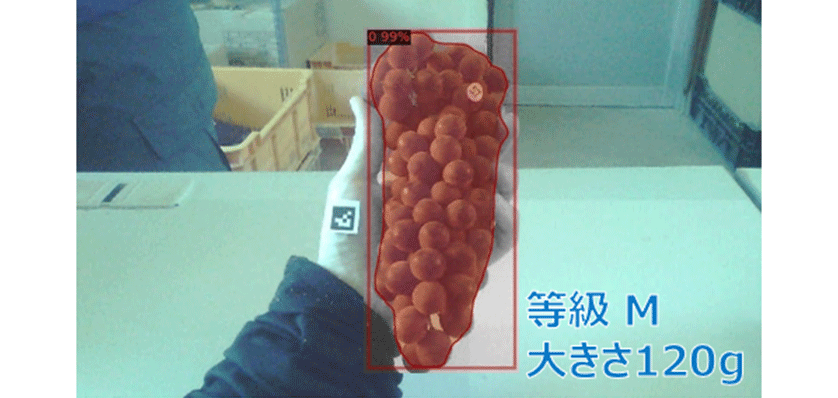

また、作物の実サイズと重量をあらかじめ計測したデータセットを用意し、それらの相関を事前に計算しておくことにより、推定した作物の実サイズから作物の重量を統計的に推定することが可能である。例えばブドウにおいては分析の結果、画像中のブドウ果房の面積と重量の間には正の相関があることがわかった。そこで、推定したブドウ果房の面積を説明変数とする回帰モデルを用いてブドウの重量を推定する手法を考案した(図3)。

2.2. エッジコンピューティング技術

学習済みのAIモデルが新しいデータに対して学習した知識を基に判断(以下、推論という)を行うには、GPU(Graphics Processing Unit)を用いた強力な演算能力が必要である。このため、AIを含んだシステムはクラウドサーバで一連の処理が完結する形で構築されることが多い。しかしながら、エッジデバイスとクラウドは演算能力や応答時間などの特性が異なっているため、適用先やコストなどを考慮して適切なものを都度選択する必要がある(表1)。特に、農業の現場は電波が届きづらい場合があるので、クラウドと常時通信を行うことは好ましくない。当社では農業の現場でAIによる推論を行えるよう、エッジコンピューティング技術を用いたシステムを構築した。エッジデバイスの演算能力はクラウドや自社で管理するサーバと比べると非常に低いので、AIモデルを軽量化し、比較的軽量なフレームワークを採用した。

表1. エッジデバイス利用とクラウド利用の比較

| エッジデバイス利用 | クラウド利用 | |

|---|---|---|

| 演算能力 | 低い | 可変 |

| 応答時間 | 速い | 遅い |

| インターネット通信環境 | 不要 | 必須 |

3. 事例紹介

本章では、上記技術を採用した農作業支援システム『営農スマートガイド』のシステムアーキテクチャと、2件の適用事例について紹介する。また、エッジコンピューティング技術の実用性評価の一例として、システム応答時間の計測結果を示す。

3.1. システムアーキテクチャ ~『営農スマートガイド』~

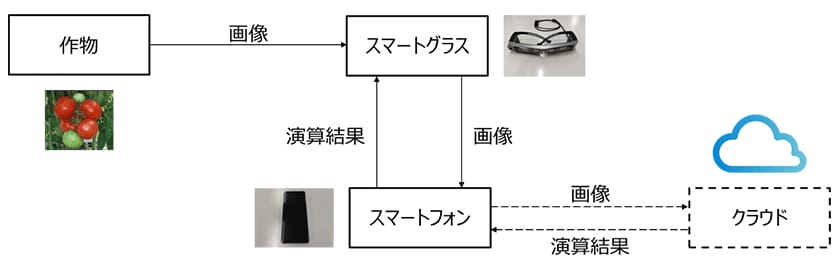

『営農スマートガイド』は作業者の作業品質の均質化という課題を解決するために開発した、スマートグラスおよびスマートフォンから成る、2章で紹介した技術を搭載した農業支援システムである(図4)。ユーザインターフェースにスマートグラスを採用することにより、ハンズフリーでの画像取得・情報参照を可能とした。スマートグラス内蔵のカメラにより作物の画像を取得し、画像認識AIによる推論の結果をスマートグラスのディスプレイに表示することにより作業者を支援する仕組みとなっている。スマートフォンはエッジデバイスとして画像認識AIを用いた推論やスマートグラスに描画する情報の生成を行う。高い演算能力が必要な場合には、スマートフォンを介してクラウドで推論を行うことも可能である。

3.2. 複数の作物の収穫可否判定

1件目の適用事例として、2.1.1.で述べた色味判定技術を用いた収穫可否判定を紹介する。ナシ2品種(幸水、豊水)・ブドウ・イチゴの各作物について、物体検出モデルを作成し、その出力に基づいて収穫可否判定を行った。作業者はスマートグラスに投影される画像を通して収穫可否判定結果を確認することができる。ナシを例に挙げると、検出したナシのうち適熟果には「Just」ラベルを、未熟果には「Early」ラベルを付加して作業者に情報を提示しているので、誤った収穫作業を抑止する効果が期待できる(図5)。

収穫可否判定の精度を検証するため、物体検出モデルがどれだけ正確に物体を検出できているかを示す指標であるmAP(mean Average Precision)の算出を行った。品種ごとに個別に物体検出モデルを作成することにより、全ての作物でmAP > 0.8を実現した(表2)。深層学習の研究分野でよく用いられているPascal VOCデータセットに対して主要な画像認識AIで推論を行った場合のmAPは0.66~0.76と報告されている(2)。mAPの値と現実的なタスクとの明確な紐づけは難しいものの、これらの先行研究と同程度以上のmAPが得られることを確認した。

表2. 各作物の収穫可否判定の結果

| ナシ(幸水) | ナシ(豊水) | ブドウ (デラウェア) |

イチゴ | |

|---|---|---|---|---|

| AIの支援機能 | 収穫可否判定 | 収穫可否判定 | 熟度推定 | 収穫可否判定 |

| 付与ラベル (分類クラス) |

Early / Just | Early / Just | 着色0% / 20% / 40% / 60% / 80% / 100% | Red / Not red |

| 学習データ数 | 301枚 | 536枚 | 5,463枚 | 525枚 |

| テストデータ数 | 35枚 | 135枚 | 2,256枚 | 174枚 |

| 精度(mAP) | 0.93 | 0.84 | 0.88 | 0.80 |

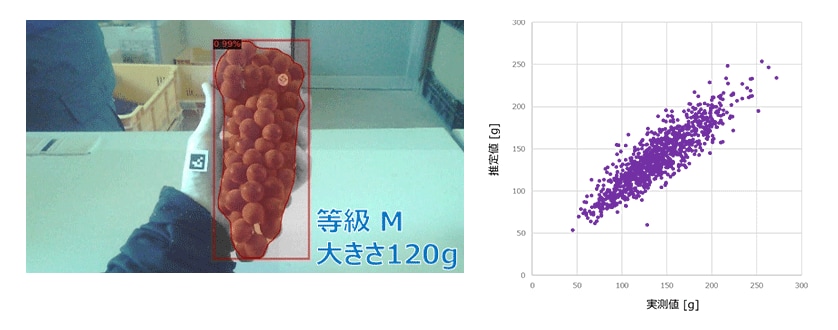

3.3. ブドウの重量推定

2件目の適用事例として、2.1.2.で述べた形状判定技術を用いたブドウの重量推定を紹介する。セグメンテーションモデルと回帰モデルを作成し、その出力に基づいて重量推定を行った。作業者は『営農スマートガイド』を用いてブドウおよびARマーカの画像を取得することにより、農業の現場で重量推定結果を得られる(図6左)。また、推定値と実測値には強い相関があることを確認している(図6右)。

『営農スマートガイド』の重量推定精度を検証するため推定値と実測値の合致率を算出し、未習熟者4名の目視による推定結果と比較した。その結果、『営農スマートガイド』の合致率は未習熟者より統計的に有意に高かった(表3)。このことは、システムが適切に活用されれば未習熟者支援の効果が期待できることを示している。

表3. t検定の結果

| 変数 | 『営農スマートガイド』(n = 1082) | 未習熟者(n = 80) | p値 | 平均値差の95%信頼区間 [%] | ||

|---|---|---|---|---|---|---|

| 平均値 [%] | 標準偏差 [%] | 平均値 [%] | 標準偏差 [%] | |||

| 合致率 | 89.4 | 9.32 | 84.9 | 9.55 | 0.0000461 (< 0.05) |

[2.34, 6.76] |

- ※等分散を仮定しないWelchのt検定(片側、有意水準0.05)

- ※合致率 [%] = 100 – MAPE(Mean Absolute Percentage Error)

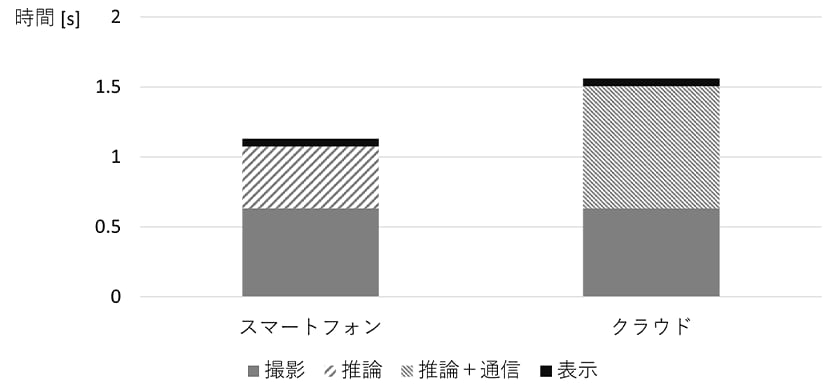

3.4. システム応答時間

2.2.で述べたエッジコンピューティング技術の実用性を確認する目的で、軽量化した同一の物体検出モデルについて、演算をスマートフォンで行う場合とクラウドで行う場合でシステム応答時間を比較した。ここで、システム応答時間は「撮影時間」「推論時間」「データ通信時間」「推論結果表示時間」の総和と定義した。また、これらのうち撮影時間と推論結果表示時間については、共通のスマートグラス/スマートフォンを使用したため同一の値となる。

計測の結果、スマートフォンを用いた場合のシステム応答時間は1.125 sであり、クラウド推論のシステム応答時間は1.555 sであった(表4、図7)。スマートフォンはデータ通信時間がかからないもののクラウドと比べて演算能力が低いため推論時間が多くなるというトレードオフがあるが、物体検出タスクにおいてはエッジコンピューティング技術でもクラウドを用いた場合より速いシステム応答時間を得られることを確認した。

表4. システム応答時間およびその内訳

| 撮影時間 [s] | 推論時間 [s] | データ通信時間 [s] | 推論結果表示時間 [s] | システム応答時間 [s] | |

|---|---|---|---|---|---|

| スマートフォン | 0.63 | 0.44 | 0 | 0.055 | 1.125 |

| クラウド | 0.87 | 1.555 | |||

4. おわりに

本稿では、農業の大規模化・法人化に伴い発生している作業者の作業品質の均質化という課題の解決策として、画像認識AIを搭載した農作業支援システムを紹介した。収穫可否判定と重量推定への適用を行い、それぞれ未習熟者の支援となり得る精度を示した。またエッジコンピューティングの有効性について、システム応答時間の比較評価を行い、クラウドを用いた場合と遜色ないシステム応答時間が得られることを確認した。いずれの形態でもシステム応答時間は良好な値を示し、作業者にストレスを感じさせることなく農作業支援情報を提示することが可能となった。

AIの分野は画像認識に限らず急速な進展を見せており、近い将来人間の判断精度や判断速度を上回ることが予想される。こうしたAIの能力を実際の農業の現場に適用し、人間にとって有用なものとしていくためには、農作業支援やエッジコンピューティング技術の観点から課題を抽出し、技術開発を進めることが不可欠である。引き続き、AI技術の高度化と実装を進め、農業に関わる人々に役立つAIおよびAI搭載製品の提供を目指していく。

謝辞

本研究の一部は生物系特定産業技術研究支援センター「戦略的スマート農業技術等の開発・改良」(2022~2024年度)の支援を受け、明治大学および大阪府立環境農林水産総合研究所と共同で行った。記して謝意を示す。

引用文献

- (1)一般社団法人日本施設園芸協会(2023):大規模施設園芸・植物工場 実態調査・事例調査, https://www.maff.go.jp/j/seisan/ryutu/engei/sisetsu/attach/pdf/index-17.pdf,(accessed 2025-10-29).

- (2)Neha, F., Bhati, D., Shukla, D. K., and Amiruzzaman, M.(2025): From classical techniques to convolution-based models: A review of object detection algorithms, IEEE 6th International Conference on Image Processing, Applications and Systems, 1-6.

著者